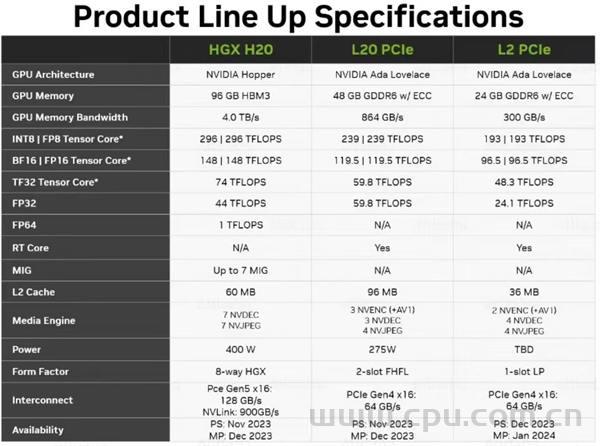

据产业链人士消息,英伟达现已开发出针对中国区的最新改良版系列芯片:HGX H20、L20 PCle和L2 PCle。知情人士称,最新三款芯片是由H100改良而来,英伟达最快或将于本月16号之后公布,国内厂商最快将在这几天拿到产品。截至发稿,英伟达方面暂无回应。

附H100参数:

H100 采用了当前最先进的台积电 4nm 工艺、单块芯片拥有800 亿个晶体管,可以加快 AI、HPC、内存带宽、互连和通信的发展,甚至能够实现每秒近 5 兆字节的外部连接,是第一个支持PCle Gen5和利用HBM3的GPU,使记忆体频宽达到3TB/s。

硬件层级上,A100有108个SM,而H100 SM提升到了132个,H100 SM数量的提升带来2倍性能增益。其中每个SM里有 128个FP32 CUDA Core,配备了第四代Tensor Core,可以在同时脉的前提下,提升2倍相比于A100的稠密(Dense)或稀疏(Sparse)运算的原始性能。(注:在安培架构,是有复用 INT32 部分,H100的FP32 CUDA Core是独立的,在没复用的情况下把 FP32 CUDA Core数量翻倍。)

全新的张量数据处理格式FP8 。FP64/FP32 60TFlops(每秒60万亿次),FP16 2000TFlops(每秒2000万亿次),TF32 1000TFlops(每秒1000万亿次),都三倍于A100。H100的FP8 算力是4000TFlops(每秒4000万亿次),六倍于A100。(FP8相比于FP16,拥有更少的内存占用,且向量化程度更高,吞吐即会有提升)

新的 Transformer Engine 结合了软件和定制的 Hopper Tensor Core 技术,专门用于加速 Transformer 模型的训练和推理,其集合了新的 Tensor Core、FP8 和 FP16 精度计算,以及 Transformer 神经网络动态处理能力,可以将此类机器学习模型的训练时间从几周缩短到几天,与上一代 A100 相比,在语言模型的训练和推理过程中,训练速度比上一代快了9倍,推理速度快了30倍。

新的线程块集群(Thread Block Cluster)架构。该架构以比单个 SM 上的单个线程块更大的粒度开放了对局部性的控制。通过向原有的编程层级结构添加另一个级别来扩展 CUDA 编程模型,现在包括thread、thread block、thread block cluster和grid。block集群使多个线程块在多个 SM 上同时运行,以同步和协作获取和交换数据。(注:一个SM可以包含多个SP。thread是一个线程,多个thread组成一个线程块block,多个block又组成一个线程网格grid。)

张量记忆加速器 (Tensor Memory Accelerator)。新的张量内存加速器 (TMA) 提高了数据获取效率,TMA 通过复制描述符启动,使用张量维度和块坐标指定数据传输,而不是按元素寻址,其指定大数据块并将其从全局内存加载到共享内存或从共享内存存储回全局内存。TMA 通过支持不同的张量布局(1D-5D 张量)、不同的内存访问模式、缩减和其他功能,显著降低了寻址开销并提高了效率。

支持第四代 NVLink 技术。将 NVLink 与新的外部 NVLink Switch 相结合,NVLink 作为扩展网络扩展到服务器,与使用 NVIDIA HDR Quantum InfiniBand 的上一代相比,最多可以连接多达 256 个 H100 GPU,带宽也高出了 9 倍。

针对服务器实际应用,H100 可以虚拟化为 7 个用户共同使用,每个用户获得的算力相当于两块全功率的 T4 GPU。对于商业用户来说,H100 实现了业界首个基于 GPU 的机密计算。